https://arxiv.org/abs/2404.14687

Pegasus-v1 Technical Report

This technical report introduces Pegasus-1, a multimodal language model specialized in video content understanding and interaction through natural language. Pegasus-1 is designed to address the unique challenges posed by video data, such as interpreting sp

arxiv.org

Abstract

트웰브랩스(Twelve Labs)에서 발표한 동영상 콘텐츠 이해 및 자연어 상호작용에 특화된 멀티모달 언어 모델인 Pegasus-1에 대해 쓴 논문이다. Pegasus-1은 시공간 정보를 해석하여 다양한 길이의 동영상 콘텐츠를 세밀하게 이해할 수 있도록 설계되었다. 이 기술 보고서에서 Pegasus-1의 아키텍처, 학습 전략, 그리고 동영상 대화, 제로샷 동영상 질의응답, 동영상 요약과 같은 벤치마크에서의 성능에 대해 개괄적으로 설명한다. 또한 Pegasus-1의 능력과 한계를 보여주며, 현재 상태와 향후 방향에 대한 균형잡힌 관점을 제공하기 위해 질적 특성을 탐구한다.

1. Introduction

점점 진화하는 대형 언어모델 (LLM) 분야에서 LLM의 동영상 이해 능력을 개발하는 것은 혁신과 실용성의 최전선으로 떠오르고 있다. 이 기술 보고서에서는 자연어를 통해 동영상 콘텐츠를 해석하고 생성하며 상호작용할 수 있는 최첨단 멀티모달 모델인 Pegasus-1을 소개하고 분석한다.

Pegasus-1의 주요 목표는 단일 형식 내에 여러 모달리티가 포함된 동영상 데이터의 고유한 문제를 극복하는 것이다. 이러한 이해에 있어 중요한 요소는 시각적 데이터의 시간적 순서를 해석하여 움직임과 변화의 본질을 포착하고, 각 프레임 내에서 공간적으로 세부적인 부분을 제공하는 것이다. 동시에, 시각적 요소의 해석을 향상시키고 동영상 콘텐츠의 미묘한 이해를 보장하기 위해 오디오 정보를 통합해야한다. 또한, 짧은 클립부터 긴 영상에 이르기까지 다양한 동영상 길이를 처리하는 것이 필수적인 요소이다.

이 기술 보고서에서는 이러한 문제를 해결하기 위한 Pegasus-1의 접근 방식을 논의하여 동영상 콘텐츠를 종합적으로 이해할 수 있도록 하는 방법을 설명한다. 여기에는 모델 아키텍처, 학습 데이터, 학습 전략에 대한 간략한 설명이 포함되어 있으며, Pegasus-1의 advanced 동영상 이해 능력에 기여하는 요소들에 대한 폭넓은 관점을 제공한다.

2. Model Architecture and Training

2.1 Model Architecture

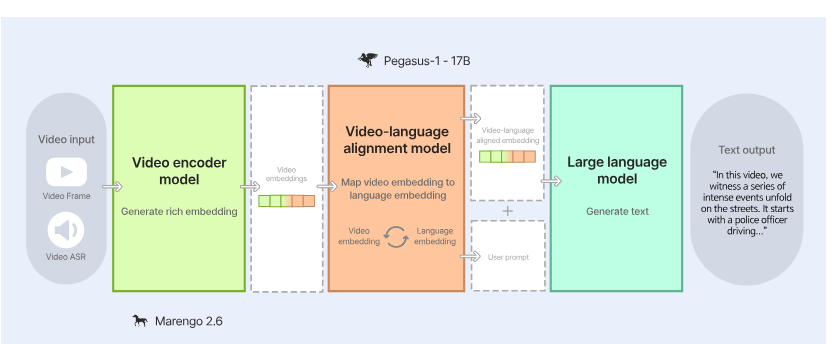

동영상 데이터를 효율적으로 이해하기 위해서는 청각 및 시각 정보를 매끄럽게 통합하면서 긴 동영상 길이를 효과적으로 관리하는것이 중요하다. 트웰브랩스의 아키텍처 전략에서는 오디오와 시각적 데이터를 함께 처리할 수 있는 아키텍처를 개발했으며, 이는 긴 동영상에 맞춘 효율적인 계산을 특징으로 한다. 그림 1에서 보여지듯, Pegasus-1은 인코딩, 정렬, 디코딩을 위한 종합적인 삼분체 프레임 워크로 구성되어있다.

- 비디오 인코더 모델 : Marengo 2.6을 기반으로 한 비디오 인코더 모델은 비디오 입력을 처리하여 비디오 프레임과 오디오 음성 인식 (ASR)데이터를 포함한 풍부한 임베딩을 생성한다. 이러한 임베딩은 동영상 콘텐츠의 시각적 및 청각적 본질을 포착하는 밀집된 표현이다.

- 비디오-언어 정렬 모델 : 이 모델은 비디오 임베딩을 해당 언어 임베딩에 매핑하여, 비디오와 텍스트 표현이 일관되게 정렬된 공통 공간을 형성한다. 이러한 정렬은 모델이 비디오의 시각적 콘텐츠와 그 설명적 언어를 효과적으로 구분하고 연관시키는 데 중요하다. 또한, 긴 동영상 길이 처리를 향상시키기 위해, 대형 언어 모델 내에서 입력 토큰 크기를 최소화하는 토큰 감소 기술을 사용하여 계산 효율성을 최적화하고 긴 시간 동안 문맥의 무결성을 유지한다.

- 대형 언어 모델(디코더 모델): 대형 언어 모델 디코더는 정렬된 임베딩과 사용자 프롬프트를 받아 일관되고 문맥에 맞는 텍스트 출력을 생성한다. 이 출력은 동영상 콘텐츠에 대한 설명적 요약부터 특정 질문에 대한 답변에 이르기까지 다양할 수 있다. 이 대형 언어 모델 디코더는 동영상 데이터의 긴 문맥을 효율적으로 처리하기 위해 효율적인 어텐션 메커니즘을 활용한다.

2.2 Training

최첨단 멀티모달 기초 모델인 Pegasus-1의 학습은 시각 및 오디오 모드를 포함한 동영상 데이터의 다양한 모달리티를 조화롭게 이해하는데 중점을 둔다. 이를 위해 각 모달리티의 고유한 강점을 활용하였으며, 이미지 데이터에서 공간적 이해를 적용하고 오디오 데이터에서 강력한 오디오 이해를 위한 insight를 도출해냈다. 특히, 동영상은 독립적인 이미지나 오디오보다 풍부한 정보 소스를 가지고 있음에도 불구하고, 고품질 동영상 데이터는 많지 않다. 이러한 문제를 해결하기 위해 학습을 위한 방대한 양의 독점 텍스트 주석을 주집했다고한다. 구체적으로, 약 1천만 개 이상의 다양한 동영상을 매우 상세한 설명으로 주석처리 했고, 이러한 설명은 각 동영상에 나타나는 대부분의 이벤트를 포착하며, 활동 및 객체에 대한 상세한 실세계 지식, 특정 객체의 이름, 다양한 스포츠의 기술 용어등을 포함한다.

Pegasus-1의 학습 과정은 사전 학습 단계(pretraining phase)와 명령 튜닝 단계(instruction tuning phase)의 두 단계로 구성된다. 사전 학습 단계에서는 비디오 인코더와 대형 언어 모델을 사전 학습된 가중치로 초기화한 후, 앞서 언급한 풍부한 상세 동영상 데이터를 포함한 대규모 멀티모달 데이터셋으로 학습을 진행한다. 두 번째 단계에서는 독점적인 멀티모달 명령 데이터셋을 활용하여 모델의 사용자 명령에 대한 반응성을 정제하는 지도 학습 명령 미세 조정(supervised instruction finetuning)을 수행한다. 하지만, 이러한 다단계 학습에서 주요한 도전 과제는 파국적 망각(the risk of catastrophic forgetting)의 위험으로, 이는 사전 학습된 모델이 새로운 정보를 수용하면서 이전에 획득한 지식을 잃어버리는 현상이다.

이를 완화하기 위해, 학습 전략은 신중하게 계획된 두 단계를 포함하여, 새로운 데이터의 통합을 조화롭게 진행하면서 기존 지식을 보존하도록 설계했다고 한다. 이 전략의 핵심은 모델 파라미터의 선택적 해동(the selective unfreezing of model)과 학습 진행 중 학습률의 정밀한 조정을 결합하는 것이다. 이러한 접근 방식은 Pegasus-1이 새로운 기능을 효율적으로 습득할 뿐만 아니라, 이전에 학습된 기술을 유지하고 정제하여 advanced 동영상-언어 이해를 위한 강력한 기초를 확립할 수 있게 해주었다고한다.

3. Results on Benchmarks

3.1 Comparison Models

- Gemini models (proprietary): Gemini는 Google의 독점적인 멀티모달 모델로, 비디오-언어 작업에서 최첨단 성능으로 잘 알려져있다. 비교 분석의 정확성과 관련성을 보장하기 위해, Video Question Answering 벤치마크에서 Geminio 1.0 및 Gemini 1.5의 성능을 Google의 기술 보고서에서 발췌했다고 한다. 비디오 대화 및 요약과 같이 그들의 보고서에 포함되지 않은 다른 벤치마크의 경우, 2024년 2월 17일에 공개된 Gemini API버전을 사용하여 테스트를 했다고 한다.

- OpenSource models : VideoChat, Video-ChatGPT, Video LLAMA, BT-adapter, LLAMA-VID, VideoChat2와 비교했다.

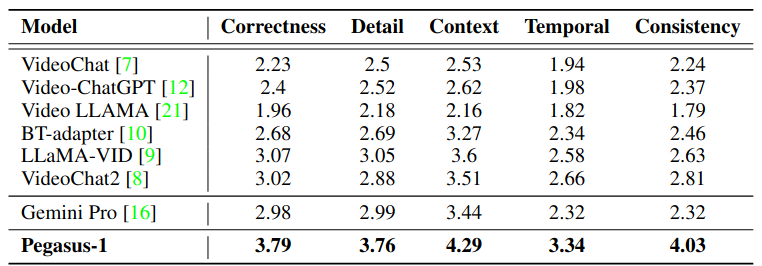

- 비디오 대화 벤치마크: 표1에서 비디오 기반 대화 벤치마크에서 Pegasus-1의 평가결과를 보여준다. Pegasus-1이 비디오 대화의 맥락에서 강력한 성응을 발휘하며, 다양한 평가 차원에서 주목할 만한 성과를 달성했다. 특히, Pegasus-1은 정확성에서 3.79, 맥락에서 4.29의 점수를 기록하여 비디오 대화 콘텐츠와 관련된 맥락을 효과적으로 처리하고 이해함을 나타낸다. 이러한 점수는 정확성, 세부 사항, 맥락 인식, 시간적 이해 및 일관성 같은 핵심 영역에서의 Pegasus-1의 성능을 나타내며, 비디오 기반 대화를 해석하고 응답하는 능력을 강조한다.

- 제로샷 비디오 질의응답: 표 3에서 두가지 인기있는 제로샷 비디오 질의응답 벤치마크인 ActivityNet-QA와 NExT-AQ에서 Pegasus-1의 성능을 상세히 설명해준다. 비디오 질의응답 작업에서, Pegasus-1은 ActivityNet-QA와 NExT-AQ 데이터셋에서 오픈소스 모델 및 Gemini 시리즈와 비교하여 제로샷 능력에서 상당한 향상을 보여줬다. 생성된 응답은 GPT-3.5 Turbo에 제공되어 예측이 실제 정답과 일치하는지 여부를 결정하는데 사용된다.

- 비디오 요악: 비디오 요약 성을을 평가하기 위해, 비디오 대화 벤치마크를 따르고 생성된 요약을 정보의 정확성, 세부 지향성, 맥락 이해의 세 가지 영역에서 평가한다. GPT-4는 각 지표에 대한 점수를 기준 요약을 실제 정답으로 설정하여 측정한다. 비디오 대화 벤치마크에서 제안된 ActivityNet 상세 캡션 데이터셋을 사용하여, 표 4에서 이 결과를 보여준다. 위에서 보듯이, Pegasus-1은 모든 지표에서 높은 성과를 거두었다.

- 시간적 이해: 비디오 언어 모델인 Pegasus-1은 비디오의 시간적 정보를 이해할 수 있어야 한다. 이 능력을 테스트하기 위해 TempCompass라는 특별한 데이터셋을 사용했다는데, 이는 비디오의 행동, 방향, 속도, 이벤트 순서, 속성 변화 등 다섯 가지 시간적 요소를 평가한다.이 평가에서는 원본 비디오를 다양한 방식으로 변형한 합성 비디오를 사용하는데, 예를 들어, 비디오를 뒤집거나, 빠르게 재생하거나, 느리게 재생하는 등의 조작을 통해 시각적 콘텐츠는 동일하게 유지하면서 시간적 역학이 변경된 상황을 만든다.표 2에서 보여준 결과에 따르면, Pegasus-1은 다른 오픈소스 모델들보다 뛰어난 성능을 보였으며, 특히 시간적 정보에 중점을 둔 VideoChat2를 크게 능가한다. TempCompass 데이터셋은 구문 분석이 가능한 다중 선택 QA 데이터셋 형식으로 되어 있기 때문에, Pegasus-1의 중간 출력을 사용하여 데이터를 분석한다. 이 중간 출력은 최종 응답과 동일한 정보를 전달하지만, 데이터셋의 분석 요구 사항에 맞게 조정하기 더 쉽다.

4. Capabilities of Pegasus-1

4.1 Comparison Protocol for Qualitative Results

제시된 프롬프트는 모델의 성능을 정확하게 평가할 수 있도록 명확하고 일관되게 신중하게 작성되었다. 프롬프트를 작성할 때는 과도한 모호성이나 불필요한 복잡성을 피하여 프롬프트가 직관적이고 모델의 능력을 명확하게 평가할 수 있도록 해야한다.

또한, 시각적으로 정확한 응답 능력 비교에 특히 중점을 두었고, 이는 언어 모델의 '런 오프(runoff)'로는 달성할 수 없는 능력이다. 언어 모델의 언오프란, 언어 모델이 강력한 언어적 선험 지식을 활용하여 맥락에 맞는 정보를 생성하는 경향을 말한다. 예를 들어, 대형 언어 모델(LLM)이 "해변"이라는 개념을 인식하면, 픽셀 정보에서 직접적인 증거 없이도 "맑은 날씨"나 "사람들이 수영하는 장면"과 같은 응답을 생성할 수 있다. 이 과정은 일관된 응답을 생성할 수 있지만, 시각적 콘텐츠를 정확하게 반영하지 않을 수 있다.

4.2 Characteristics of Pegasus-1

- 자세한 출력(Vebose Ouput): Pegasus-1은 지침을 정확하게 따르도록 설계되어 있으며, 비디오의 오디오 및 시각적 요소에 대한 광범위한 세부 정보를 제공한다. 그 결과, Pegasus-1의 출력은 매우 자세할 수 있으며, 질문에 대한 풍부한 정보를 제공할 수 있다. 이러한 특성은 두 가지 주요 이유로 의도된 것이다.

첫째, Pegasus-1은 채팅 인터페이스 기능을 갖추고 있지 않기 때문에, 단일 상호작용에서 포괄적인 응답을 제공하도록 설계되었다. 이는 비디오 이해 작업과 잘 맞아떨어지며, 비디오는 정부가 매우 풍부하기 때문이다.

둘째, 연구에 따르면 사용자는 짧은 응답보다 자세한 설명을 선호하는 경향이 있다.

하지만, Pegasus-1은 길고 자세한 응답을 생성하도록 강화하면 허위 정보가 생성될 수 있다. 이를 완화하기 위해, 향후 Pegasus-1의 응답에서 세부 사항 수준을 조정할 수 있는 기능을 구현할 계획이라고 한다. - 능력 범주(Categories of capabilities): Pegasus-1에 대한 관찰 결과, 비디오 이해에서 다양한 능력을 보여주었다. 이 능력들은 비디오 분석의 여러 차원에서 모델의 숙련도를 보여주며, 다음과 같은 기능들을 포함한다.

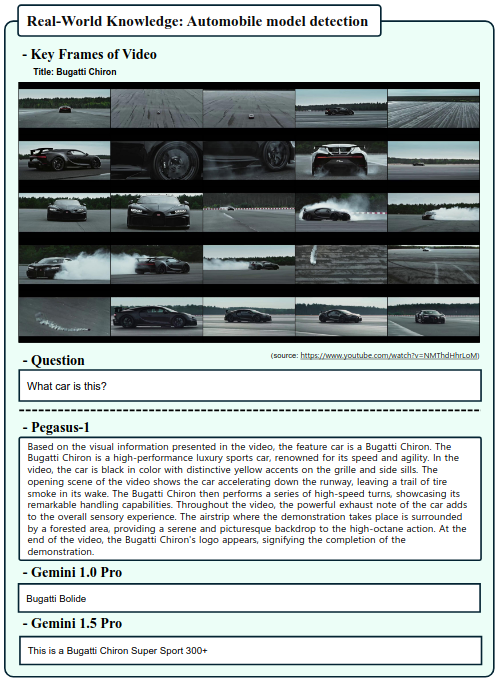

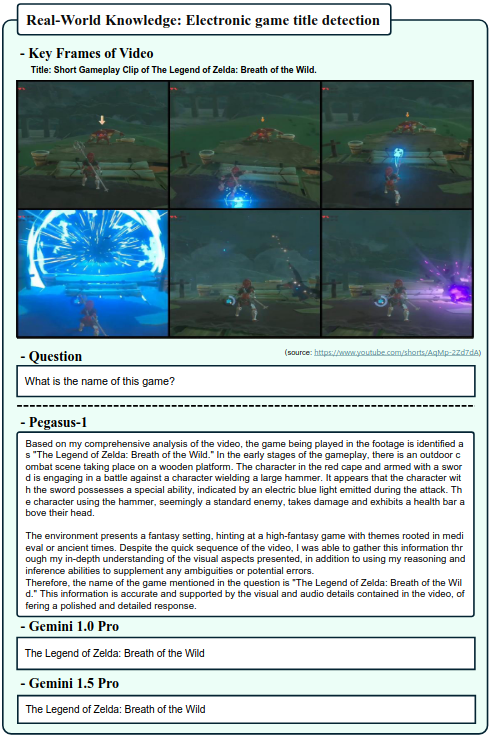

- 현실 세계 지식 : Pagasus-1은 방대한 현실 세계 지식을 통합해 비디오 콘텐츠를 정확하고 깊이 있게 맥락화하고 해석 할 수 있다.

- 비디오 기반 추록: 이 모델은 비디오 데이터에서 추론을 이끌어내어 일관된 이해와 insight를 구성하는 복잡한 추론 능력을 보여준다.

- 3D 공간 이해: Pegasus-1은 비디오 프레임 내의 3D 공간 관계를 이해할 수 있는 능력을 가지고 있어, 깊이와 공간을 이해해야하는 복잡한 장면과 객체 상호작용을 해석할 수 있다.

- 시간적 추론: Pegasus-1은 비디오 내 사건의 시간적 순서를 인식해 서사적 이해에 중요한 기능을 제공한다.

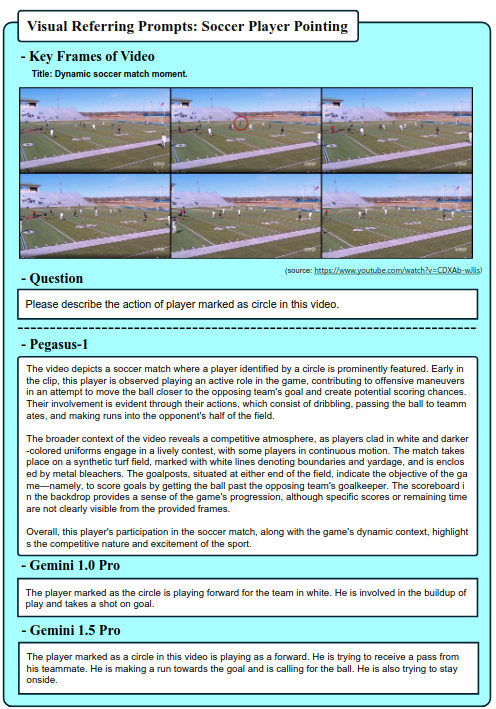

- 시간적 참조 프롬프트: 전통적인 텍스트 기반 프롬프트 방법을 넘어서, 시각적 참조 프롬프트를 채택해 픽셀 공간 내에서 직접적인 수정을 가능하게 한다. 이 advaned 접근 방식은 사용자가 화살표, 박스 또는 기타 시각적 마커를 사용하여 특정 영역을 강조하고 모델의 초점을 이러한 강조된 영역으로 유도할 수 있도로 한다.

4.3 Real World Knowledge

Pegasus-1은 비디오 콘텐츠 내에서 현식 세계의 개체를 인식하고 식별하는 데 능숙한 비디오 언어 모델이다. 다양한 비디오 시나리오에서 특정 현실 세계의 객체를 이름 붙이는 도전 과제를 통해 Pegasus-1을 평가했었다.

4.4 Video-based Reasoning

Pegasus-1은 비주얼 추론 능력도 가지고 있는데, 이는 시각적 해석과 논리적 추론의 조화를 요구한다. 비주얼 추론 작업을 효과적으로 수행하기 위해서는 이러한 능력을 통합해 정확한 답변을 제공해야한다.

4.5 3D 공간 이해 능력 평가

Pegasus-1의 3D 공간 이해 능력을 평가하기 위해, 비디오 콘텐츠에서 복잡한 공간 관계를 해석하고 탐색하는 능력에 초점을 맞춘다. 이 작업은 비디오 내 시각적 단서에서 공간 정보를 추출하고 통합하여 삼차원 공간 내에서 정확한 내비게이션 방향을 제공하는 것을 포함한다.

4.6 시간적 추론

비디오-언어 모델링의 영역에서 오디오-비주얼 콘텐츠의 순차적 성격을 이해하는 것은 필수적이다. 모델은 비디오 내에서 사건의 시간적 순서를 인식하고 유지해야 정확하게 콘텐츠를 이해하고 해석할 수 있다. Pegasus-1은 이 능력을 잘 보여주며, 사건의 시간적 순서를 효과적으로 추적하고 보존하며, 사건들의 순서에 대한 예리한 인식을 나타낸다.

4.7 시간적 참조 프롬프트 (Visual Referring Prompts)

Pegasus-1은 비디오 내의 특정 구간에 주의를 기울이는 능력을 뚜렷이 보여주며, 이는 시각적 마커에 의해 강조된 부분을 해석하고 응답하는데 중요한 역할을 한다. 이 능력은 비디오 프레임 내에서 특정 영역이나 행동을 강조하는 sign을 해석하고 반응해야 할 때 필수적이다.

4.8 다른 다양한 케이스들

5. 한계점

- 최대 비디오 길이 : 최대 15분 길이의 비디오에 최적화되어 있다. 비디오 길이가 길어질수록 시간이 먼 프레임 간의 관계를 포착하는 효율성이 감조하는 주요 한계가 있다. 더 긴 비디오를 처리하고 먼 프레임 간의 연결 정확성을 유지하는 능력을 향상시키는 것이 주 목표이다.

- 환각: Pegasus는 다른 시각-언어 모델과 마찬가지로 환각 현상이 발생할 수 있다. 이는 존재하지 않는 객체, 행동, 또는 사건의 순서를 부정확하게 식별하는 경우로 나타난다. 이러한 부정확성은 모델의 해석 정확성을 더욱 개선할 필요가 있다.

- 안전성 및 편향 : 안전성과 편향은 중요한 문제이다. Pegasus는 훈련 데이터에 존재하는 편향을 무의식적으로 perpetuate할 수 있으며, 이는 고정관념이나 잘못된 인식을 줄 수 있다. 또한, 모델은 부적절하거나 유해한 콘텐츠를 검증하거나 생성할 수 있으며, 잘못된 정보가 확산될 위험이 있다. 시각적 단서에 의존해 해석하는 것은 이러한 문제를 더욱 복잡하게 만든다. 현재 Pegasus의 능력은 사회적 맥락과 역학의 복잡성을 완전히 이해하지 못해, 맥락에 맞지 않는 결과를 생성할 수 있따. 이러한 문제를 완화하기 위해서는 더 공정하고 윤리적인 모델을 개발하고 콘텐츠 검토 메커니즘을 개선하는 전략이 필요하다.

- 채팅 기능 : 현재 Pegasus는 채팅 기능이 없다. 향후 버전에서 채팅 기능을 추가할 계획은 있으며, 이는 모델의 상호작용성과 사용자 참여를 향상시키기 위한 목표이다.

Official Website: https://www.twelvelabs.io/

Multimodal AI that understands videos like humans

Bring human-like video understanding to any application, whether you have terabytes or petabytes of video

www.twelvelabs.io

'논문' 카테고리의 다른 글

| [NEW] Yolov13 논문 리뷰 (1) | 2025.10.02 |

|---|---|

| [NEW] Ultralytics Yolov11 리뷰 (6) | 2024.10.08 |

| [논문 리뷰] EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks (0) | 2024.09.06 |

| [논문] YOLOv10: Real-Time End-to-End Object Detection 리뷰 (0) | 2024.08.21 |

| [논문] YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors 리뷰 (0) | 2024.08.21 |